Định nghĩa Hadoop

Hadoop hay Apache Hadoop là một framework có mã nguồn mở được sử dụng để lưu trữ và xử lý hiệu quả các tập dữ liệu có kích thước lớn từ gigabyte cho đến petabyte. Thay vì sử dụng một máy tính lớn để lưu trữ và xử lý dữ liệu, Hadoop cho phép bạn phân cụm nhiều máy tính để phân tích đồng thời các Big Data một cách nhanh chóng hơn.

Hadoop được phát triển bởi Doug Cutting và Michael J. Cafarella, công cụ này sử dụng mô hình lập trình MapReduce để lưu trữ và truy xuất dữ liệu nhanh hơn từ các nút của nó. Bên cạnh đó, Hadoop dựa trên cơ chế streaming nên khi được viết bằng ngôn ngữ Java sẽ cho phép bạn phát triển các ứng dụng dạng phân tán dựa vào các loại ngôn ngữ lập trình khác như: C++, Python, Perl…

Hiện nay, khi nhiều ứng dụng đang tạo ra một số lượng Big Data cần xử lý, Hadoop đang đóng một vai trò rất quan trọng trong thế giới cơ sở dữ liệu.

Lịch sử phát triển của Hadoop

Khi các công ty chuyên về công cụ tìm kiếm như Yahoo và Google phát triển đã thúc đẩy Apache Hadoop ra đời, do nhu cầu xử lý một khối lượng lớn Big Data ngày càng tăng và khả năng cung cấp kết quả trên web nhanh hơn. Lấy cảm hứng từ Google’s MapReduce, một mô hình lập trình chia ứng dụng thành các phân số nhỏ để chạy trên các nút khác nhau, Doug Cutting và Mike Cafarella bắt đầu triển khai Hadoop vào năm 2002 khi đang làm việc trong dự án Apache Nutch.

Theo một bài báo trên New York Times, Doug đặt tên Hadoop theo tên con voi đồ chơi của con trai mình. Vài năm sau, Hadoop bị tách khỏi Nutch. Khi Cutting gia nhập Yahoo, ông đã phát hành Hadoop dưới dạng một dự án mã nguồn mở vào năm 2008. Và cuối cùng, Apache Software Foundation (ASF) đã đưa Hadoop ra mắt công chúng vào tháng 11 năm 2012 với tên gọi Apache Hadoop.

Những phần mềm liên quan đến Hadoop

- Apache Hive: là phần mềm kho dữ liệu chạy trên Hadoop và cho phép người dùng làm việc với dữ liệu trong HDFS bằng cách sử dụng ngôn ngữ truy vấn giống SQL, được gọi là HiveQL.

- Apache Impala: là cơ sở dữ liệu phân tích có mã nguồn mở

- Apache Pig: là một công cụ thường được sử dụng với Hadoop để phân tích các bộ Big Data được biểu diễn dưới dạng các luồng dữ liệu. Pig cho phép các hoạt động như nối, lọc, sắp xếp, tải,..

- Apache Zookeeper: là một dịch vụ tập trung cho phép xử lý phân tán có độ tin cậy cao.

- Apache Sqoop ™: là một công cụ được thiết kế để truyền số lượng lớn dữ liệu một cách hiệu quả giữa Apache Hadoop và các kho dữ liệu có cấu trúc như hệ cơ sở dữ liệu.

- Apache Oozie: là một hệ thống lập lịch các trình quy trình làm việc để quản lý những công việc trong Apache Hadoop.

Tại sao Hadoop lại quan trọng?

Khả năng xử lý một lượng lớn dữ liệu

Hadoop cung cấp khả năng lưu trữ và xử lý một lượng lớn bất kỳ loại dữ liệu nào. Điều này đặc biệt quan trọng khi khối lượng và sự đa dạng của dữ liệu không ngừng tăng lên, đặc biệt là từ các phương tiện truyền thông xã hội và Internet of Things (IoT).

Khả năng tính toán

Mô hình điện toán phân tán của Hadoop xử lý Big Data một cách nhanh chóng. Bạn sử dụng càng nhiều nút máy tính, bạn càng có thêm nhiều sức mạnh để xử lý.

Khả năng chịu lỗi

Xử lý dữ liệu và ứng dụng sẽ được bảo vệ khỏi các lỗi phần cứng. Nếu một nút gặp trục trặc, các công việc sẽ tự động được chuyển sang các nút khác để đảm bảo tính toán phân tán không bị lỗi. Đồng thời các bản sao của dữ liệu đều được lưu trữ tự động.

Tính linh hoạt

Không giống như các hệ quản trị cơ sở dữ liệu truyền thống, Hadoop có thể giúp bạn lưu trữ bao nhiêu dữ liệu tùy thích và được phép quyết định cách sử dụng chúng sau này. Bao gồm dữ liệu phi cấu trúc như văn bản, hình ảnh và video.

Miễn phí và dễ mở rộng

Đây là một framework mã nguồn mở nên hoàn toàn miễn phí. Ngoài ra, bạn cũng có thể dễ dàng phát triển hệ thống của mình để xử lý nhiều dữ liệu hơn bằng cách thêm các nút.

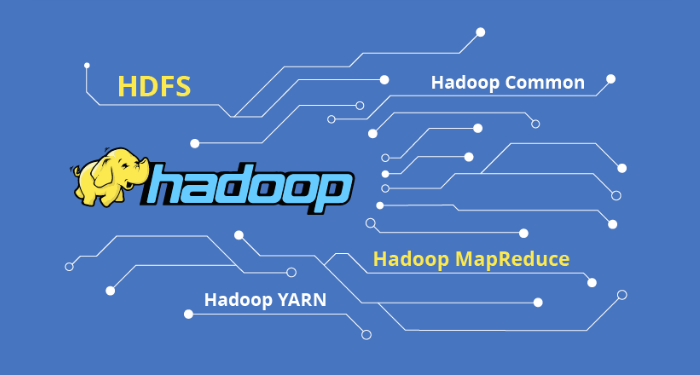

Cấu trúc của Hadoop

Hadoop được tạo thành từ các modules, mỗi modules sẽ thực hiện một nhiệm vụ cụ thể cần thiết cho hệ thống máy tính đã được thiết kế để phân tích Big Data.

Hệ thống tệp phân tán

Hệ thống tệp phân tán là phương thức được máy tính sử dụng để lưu trữ dữ liệu. Thông thường hệ thống tệp được xác định bởi hệ điều hành của máy tính. Tuy nhiên, Hadoop sử dụng một hệ thống tệp của riêng biệt nằm trên hệ thống tệp của máy tính chủ. Điều này có nghĩa Hadoop có thể được truy cập bằng bất kỳ máy tính nào và chạy bất kỳ hệ điều hành nào.

MapReduce

MapReduce được đặt tên theo hai hoạt động cơ bản mà modules này thực hiện, bao gồm đọc dữ liệu từ cơ sở dữ liệu, đưa chúng vào định dạng phù hợp để phân tích (bản đồ) và thực hiện các thuật toán.

Hadoop Common

Hadoop Common cung cấp các công cụ (bằng Java) cần thiết cho hệ thống máy tính của người dùng (Windows, Unix hoặc hệ điều hành khác) để đọc dữ liệu được lưu trữ trong hệ thống tệp Hadoop.

YARN

YARN là modules cuối cùng của Hadoop có chức năng quản lý tài nguyên của hệ thống lưu trữ dữ liệu và thực hiện các phân tích.

Cách thức hoạt động của Hadoop

Quá trình hoạt động của Hadoop gồm 3 giai đoạn.

Giai đoạn 1

Một user hay một ứng dụng sẽ submit một job lên hệ thống Hadoop (hadoop job client) cùng với những yêu cầu xử lý các thông tin cơ bản gồm:

- Truyền dữ liệu lên máy chủ (input) để bắt đầu phân tán dữ liệu và xuất kết quả (output).

- Các dữ liệu sẽ được xử lý thông qua 2 hàm chính là map và reduce. Trong đó, Map có chức năng quét qua toàn bộ dữ liệu và phân tán chúng thành các dữ liệu con. Còn Reduce có chức năng thu thập các dữ liệu còn lại và sắp xếp chúng.

- Các thiết lập cụ thể liên quan đến job thông qua các thông số được truyền vào.

Giai đoạn 2

Hệ thống Hadoop tiến hành submit job bao gồm file jar, file thực thi và bắt đầu thiết lập lịch làm việc (JobTracker) sau đó đưa job vào hàng đợi .

Sau khi tiếp nhận yêu cầu từ JobTracker, Máy chủ “mẹ” (master) sẽ phân chia công việc cho các máy chủ “con” (slave). Các máy chủ con bắt đầu thực hiện các job được giao và trả kết quả cho máy chủ “mẹ”.

Giai đoạn 3

TaskTrackers sẽ được dùng để kiểm tra nhằm đảm bảo các MapReduce hoạt động bình thường và kiểm tra kết quả đã nhận (quá trình output).

Khi “chạy Hadoop” có nghĩa là đang chạy một tập các trình nền hoặc các chương trình thường trú tại các máy chủ khác nhau trên mạng của bạn. Những trình nền đóng một vai trò cụ thể và có một số chỉ tồn tại trên một máy chủ nhất định hoặc có thể tồn tại trên nhiều máy chủ.

Nhờ tính linh hoạt của hệ thống Hadoop, các công ty có thể mở rộng và điều chỉnh quá trình phân tích dữ liệu khi hoạt động kinh doanh của họ mở rộng. Những thông tin trên bài viết đã giúp cho bạn có cái nhìn tổng quan hơn về Hadoop, hy vọng công cụ này sẽ giúp ích cho bạn trong việc xử lý khối lượng lớn dữ liệu